-- Veröffentlicht durch One am 22:04 am 21. Aug. 2011

Da ich ja derzeit meinen Laptop auf Herz und Nieren teste hab ich mir das auch nochmal reingezogen :)

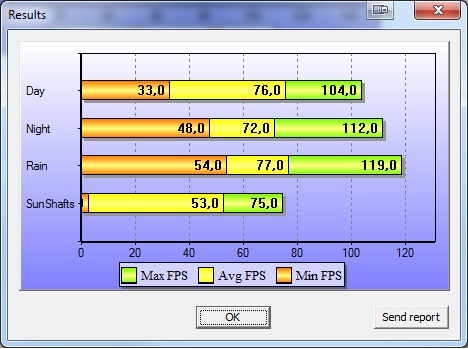

Das ganze Lief auf den Einstellungen:

Preset Medium

Renderer DX11

Auflösung 1920*1080

Hardware ist:

Intel Core i7 2630QM

nVidia GTX 560M 3GB GDDR5

8 GB Hauptspeicher

//edit

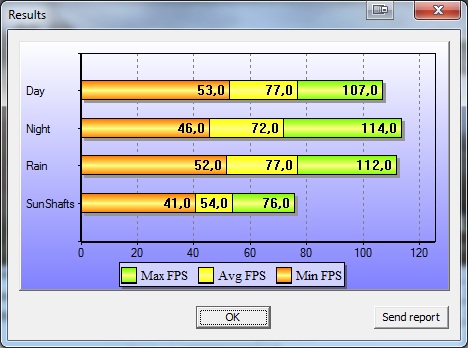

Hier nochmal in Preset High mit DX11 auf 1920*1080

(Geändert von One um 22:23 am Aug. 21, 2011)

-- Veröffentlicht durch spraadhans am 14:00 am 20. Aug. 2011

Zitat von spraadhans um 1:00 am Dez. 21, 2009 So, System wurde nochmal gequält mit 1920x1080 und Qualität auf ultra (ohne AA/AF): Day/Night/Rain/Sunshafts: 43/36/38/20 Werte, die im realen Spiel mit meinem System unerreichbar sind. Den Bench kann man zur Einschätzung, ob das Game gut läuft also knicken. |

Soooo, nachdem ich alle Stalkerteile durchgespielt habe, musste der Bench nochmal mit dem neuen System ausprobiert werden, Einstellungen wie oben:

Ergebnisse (AVG): 89/80/86/26

Die GTX285 tut also, wofür sie gekauft wurde, sie verdoppelt die fps im Vergleich zur HD4770 und das für ca. 30,-...;)

-- Veröffentlicht durch rage82 am 18:04 am 15. Jan. 2010

sohooo,

ich hab gerade mal auf standarttakt gesenkt und den bench laufen lassen, die werte entsprechen denen im übertakteten zustand.

speziell für spraadhans:

der turbo-modus arbeitet soweit, das er den multi um 3 von 4 stufen anhebt, auf 3,06ghz. 1 kern ist immer 100% ausgelastet, aber da ein 2ter mit den win aufgaben bei 10% rumdümpelt, hebt er den takt nicht maximal an.

hatte auch nen screen gemacht, hab das turbo-gadget laufen, da man da schön sehen kann, wann der turbo an is, aber das hat natürlich nicht funktioniert :/

-- Veröffentlicht durch smoke81 am 17:58 am 22. Dez. 2009

Das sind ja avg-Werte oder?

Für das Spiel ist ein Schnitt von 36-38 fps halt zu wenig.

-- Veröffentlicht durch spraadhans am 1:00 am 21. Dez. 2009

So, System wurde nochmal gequält mit 1920x1080 und Qualität auf ultra (ohne AA/AF):

Day/Night/Rain/Sunshafts: 43/36/38/20

Werte, die im realen Spiel mit meinem System unerreichbar sind. Den Bench kann man zur Einschätzung, ob das Game gut läuft also knicken.

-- Veröffentlicht durch smoke81 am 23:34 am 14. Dez. 2009

Zitat von kammerjaeger um 23:19 am Dez. 14, 2009 . Ich denke eher, dass der extreme Verbrauchsanstieg bei Dir (genauso wie bei Ht4u mit max. OC) eher auf die Spannungswandler des Boards zurückzuführen ist, die für solche Werte nicht ausgelegt sind und dann in einen sehr ineffektiven Arbeitsbereich kommen. |

So ist es! Die Belastung ist dann einfach jenseits von gut und böse.

Wobei meine Werte bei Idle und sinnvollem OC auch schon deutlich höher sind. Zum Teil kann man diese Unterschiede wohl auf die Graka, der höheren Board-NB-Spannung und RAM-Spannung, sowie den 2x ODD und 2x HDD zuordnen.

Trotzdem komme ich unter LinX problemlos über 200W und im Idle nur auf ~ 115W minimal (CPU @ 960 Mhz @ 0,9V).

Ich denke, hier kommt (zum Teil) wieder Win7 x64 ins Spiel. Die Graka wird im Idle höher belastet, aber insbesondere LinX belastet die CPU nochmals deutlich stärker. In den Einstellungen muss man dazu den 64-Bit-Modus aktivieren. Die GFlop-Anzeige von LinX steigt unter 64-Bit auch um 20-30%, genaue Zahlen habe ich gerade nicht parat. Finde ich sehr interessant :thumb:

-- Veröffentlicht durch kammerjaeger am 23:19 am 14. Dez. 2009

Zitat von smoke81 um 12:37 am Dez. 14, 2009 Doch... das Sys mit dem X4 620 @ 3,12Ghz @ 1,52V (zu Testzwecken) und LinX (zieht etwa 10% mehr als Prime95) hat maximal über 300W an der Steckdose gezogen. Graka war im Idle. Im Grenzbereich ziehen die CPUs massiv mehr Strom. Das ist bereits vom i7 bekannt, der bei größerem OC weit über 100W ZUSÄTZLICH nehmen kann... Hier ein Test von Ht4u mit einem X4 630. Während der Verbrauch bei OC mit Standardspannung (VID 1,4V) kaum anstieg, zieht die CPU bei weiterem OC und Spannungserhöhung (Spannung leider nicht angegeben, aber wohl maximal um die 1,5V) gleich über 80W mehr! Unter LinX und der Berücksichtigung des Netzteilwirkungsgrades kannst Du mit ca. 120W Mehrverbrauch rechnen... Das Gesamtsystem kommt dabei locker über 300W unter CPU-Belastung (beim Test über 330W) und die CPU gibt alleine über 200W an Abwärme ab. Dies deckt sich also vollständig mit meiner Erfahrung. |

:noidea:

Das kommt mir wirklich extrem vor! Ok, ich arbeite beim X4 620 zwar mit deutlich weniger Spannung, aber ich komme mit LinX nicht einmal über 140W (mit prime95 SmallFFTs sind es 132W, idle jeweils 89W bei vollem Takt, da kein C&Q genutzt wird)! Ich kann mir kaum vorstellen, dass 0,3V ganze 160-170W ausmachen!

Auch im Test von Ht4u ist die Spannung beim X4 630 selbst @Standard schon bei 1,441V, da das Board overvolted (klick).

Ich denke eher, dass der extreme Verbrauchsanstieg bei Dir (genauso wie bei Ht4u mit max. OC) eher auf die Spannungswandler des Boards zurückzuführen ist, die für solche Werte nicht ausgelegt sind und dann in einen sehr ineffektiven Arbeitsbereich kommen.

Ähnliches wird wohl auch beim i7 mit max. OC passiert sein.

Die Frage ist dann immer, wie lange macht das Board sowas mit?

Deshalb pflege ich den Weg des sinnvollen OC zu beschreiten. Wenn der Sprung zu den nächsten 100MHz eine deutliche Spannungserhöhung erfordert, gehe ich eher einen Schritt zurück. ;)

-- Veröffentlicht durch smoke81 am 20:03 am 14. Dez. 2009

Damit aufgrund der Graka-Übertaktung (und trotz CPU-Reduzierung) deutlich höherer AVG-Werte.

-- Veröffentlicht durch spraadhans am 19:31 am 14. Dez. 2009

Nochmal mit stabilen Einstellungen:

3000 MHz, HD4770 @ 830/850:

AVG (Day, Night, Rain, Sun): 65,58,62,44.

-- Veröffentlicht durch smoke81 am 12:37 am 14. Dez. 2009

Doch... das Sys mit dem X4 620 @ 3,12Ghz @ 1,52V (zu Testzwecken) und LinX (zieht etwa 10% mehr als Prime95) hat maximal über 300W an der Steckdose gezogen. Graka war im Idle.

Im Grenzbereich ziehen die CPUs massiv mehr Strom. Das ist bereits vom i7 bekannt, der bei größerem OC weit über 100W ZUSÄTZLICH nehmen kann...

Hier ein Test von Ht4u mit einem X4 630.

Während der Verbrauch bei OC mit Standardspannung (VID 1,4V) kaum anstieg, zieht die CPU bei weiterem OC und Spannungserhöhung (Spannung leider nicht angegeben, aber wohl maximal um die 1,5V) gleich über 80W mehr! Unter LinX und der Berücksichtigung des Netzteilwirkungsgrades kannst Du mit ca. 120W Mehrverbrauch rechnen... Das Gesamtsystem kommt dabei locker über 300W unter CPU-Belastung (beim Test über 330W) und die CPU gibt alleine über 200W an Abwärme ab.

Dies deckt sich also vollständig mit meiner Erfahrung.

EDIT: Habe gestern mehrere Tests durchforstet und die kamen so auf 3,4-3,7 Ghz. Die untere Grenze bei ca. 1,4V.

(Geändert von smoke81 um 12:39 am Dez. 14, 2009)

-- Veröffentlicht durch spraadhans am 12:10 am 14. Dez. 2009

Welches System soll 300w brauchen?

Aber nicht das mit dem 620er?

Nach den Berichten im Netz gehen die aber alle nicht wahnsinnig hoch, selbst mit Vcore-Erhöhung.

Vermutlich ist die Fertigungsqualität und/oder das Chipdesign nicht auf dem Stand der Deneb CPUs, was bei dem Preis ja auch nachvollziehbar ist.

-- Veröffentlicht durch smoke81 am 12:06 am 14. Dez. 2009

Ich habe gestern mal den CPU-Kühler in meinem Cube-Gehäuse getestet. Da passt maximal ein Big Shuriken rein.

CPU @ 3,12 Ghz mit 1,52V lt. CPU-Z... Lastverbrauch mit LinX war über 300W...! Trotzdem blieb die CPU vergleichsweise "kühl" mit maximal 62°C und damit noch innerhalb der Spezifikationen :godlike:

Aber der Verbrauch ist schon brachial, die Graka wollte ich dann nicht zusätzlich stressen, das hätte wohl tendenziell 400W an der Steckdose ergeben. Die Frage wäre insbesondere wie lange ein MB und deren Spannungswandler sowas mitmachen...

Hab außerdem die Tage mal den Jetway-Support angeschrieben, wegen dem fehlenden NB-Teiler. Vielleicht habe ich ja Glück und es kommt noch etwas per Bios-Update, das Sys schreit eigentlich nach mindestens 3,5 Ghz... :niko:

(Geändert von smoke81 um 12:08 am Dez. 14, 2009)

-- Veröffentlicht durch spraadhans am 23:26 am 13. Dez. 2009

CnQ ist standardmäßig eingestellt, ich hab da nichts verändert.

Ohne Anpassung der 4770 zeigt das Messgerät im idle immer noch nur ca. 81w, also vergleichbar mit dem letzten Dualcoresystem, das im Ergebnis schwächer war.

Unter Last habe ich bei GTA so um die 150-160w, was denke ich ebenso ein hervorragender Wert ist.

Den Stalkerbench lass ich in der stabilen config bei Gelegenheit nochmal durchlaufen...

(Geändert von spraadhans um 14:28 am Dez. 14, 2009)

-- Veröffentlicht durch smoke81 am 23:11 am 13. Dez. 2009

Der Idle-Verbrauch ist wirklich sehr gut. CnQ nutzt Du ab Werk oder mit eigenem Profil?

Verwunderlich ist eher, dass Deine CPU eine vergleichsweise hohe Spannung benötigt. Wenn Prime durchläuft, kann LinX durchaus nochmal ca. 0,05V mehr benötigen und das wären dann immerhin ca. 0,15V mehr als bei mir bei 3Ghz (bisher nicht getestet, Stabilitätsgrenze dürfte so bei 1,15-1,19V liegen).

Falls es Dein Produktivsystem ist, würde ich jede Komponente nochmals im Ausschlussverfahren unter LinX belasten. Bisher wissen wir scheinbar nichtmal, ob Dein Sys @ Standard "LinX-stable" ist.

-- Veröffentlicht durch spraadhans am 18:47 am 13. Dez. 2009

Bin jetzt bei 3 GHz und werde es so lassen (Reftakt auf 240, NB und HT Multi auf 8 = je 2000 MHz), Vcore auf 1,33v.

Das erstaunliche zum Schluss, mit aktivierten CnQ und manuell gesenktem DDR5 Takt (300 MHz) komme ich auf gerade mal 69w idle Verbrauch, das kann sich wirklich sehen lassen.

Merkwürdig an den Abstürzen ist für mich, dass immer meist ein Soundstotterer vorausgeht...Hoffentlich hat das Board keine Macke..

(Geändert von spraadhans um 14:29 am Dez. 14, 2009)

-- Veröffentlicht durch smoke81 am 13:18 am 13. Dez. 2009

Finger weg von der NB-VID! D.h. CPU-Northbridge.

Am besten Du belässt sie auf den Standard 1,175V. Habe es auch mal probiert, um den NB-Takt höher zu bekommen, aber das wurde instabil bei höheren Spannungen.

Die Board-NB habe ich minimal von 1,1V auf 1,15V angehoben. Bräuchte ich vielleicht nicht, aber schadet auch nicht. Das kannst Du im Rahmen machen, aber nicht die NB-VID (CPU) höher setzen...

Ansonsten: LinX

zum Beispiel hier

CodeWer beispielsweise Cool’n’Quiet beim Phenom II manuell mittels K10stat einstellt, der darf den Kerntakt nie so setzen, dass dieser halb so groß ist wie der Northbridgetakt. Bei einem Phenom II X4 955 BE mit 2 GHz NB-Takt darf der Idle-Takt nie bei 1,0 GHz liegen, da sonst das System stehenbleiben kann, wenn gleichzeitig ein Prozessorkern noch höher taktet als 2 GHz. |

Die beste Anleitung ist die von

P3Dnow

(Geändert von smoke81 um 13:23 am Dez. 13, 2009)

-- Veröffentlicht durch spraadhans am 13:12 am 13. Dez. 2009

Aber woher dann?

Bin jetzt bei 3000 MHz mit 1,325v (Board overvolted leicht) und das scheint vorerst stabil.

Mit niedrigeren Spannung quittiert prime recht schnell den Dienst, komischerweise nicht mit einer Fehlermeldung sondern direkt Bluescreen...

NB und HT Takt sind unter 2000 MHz, NB Spannung habe ich von 1,175 auf 1,825 angehoben, Speicher liegt bei unter 800...

Und 250 MHz Reftakt sollte doch eigentlich jedes Board schaffen...

-- Veröffentlicht durch smoke81 am 12:27 am 13. Dez. 2009

Wie gesagt, lass mal LinX laufen! Für einen Schnelltest reichen 15-20 Minuten (für den finalen Test etwa 90 Minuten). So kannst Du schnell die zickige Komponente ausfindig machen. In den meisten Fällen ergab sich bei mir bereits innerhalb der ersten 5 Minuten ein Fehler. Gut ist auch, dass das Programm Lastwechsel produziert und nicht nur immer im höchsten P-State verweilt, so werden auch diese getestet.

LinX ist meines Erachtens aufschlussreicher und sensibler als das alte Prime...

Meine CPU wurde beispielsweise mit 1,216V @ 3,25Ghz (Prime) getestet. Unter LinX und Win7 64Bit ergibt das bei mir dann immer noch 1,2125V @ 3,12Ghz.

1,4V sind wohl zuviel, wenn man sich den Durchschnitt dieser CPUs ansieht. Die Instabilität rührt vermutlich woanders her.

-- Veröffentlicht durch kammerjaeger am 11:51 am 13. Dez. 2009

Mal versucht, weniger Spannung zu geben? Klingt paradox, ist aber teilweise so...

-- Veröffentlicht durch spraadhans am 11:36 am 13. Dez. 2009

Weitere Messungen muss ich erstmal vertagen, weil irgendwas im System instabil ist.

Wenn sich mein erster Eindruck bestätigt, dann liegt es an der CPU, die trotz 1,4v nicht stabil mit 3250 MHz laufen will.

-- Veröffentlicht durch spraadhans am 21:37 am 12. Dez. 2009

So,

620 @ 3,25 GHz, 2x2 GB DDR2-833, HD4770 (std.):

Day: 42-61-82

Night: 38-54-85

Rain: 38-58-87

Sunshaft: 29-40-58

620 @ 3,25 GHz, 2x2 GB DDR2-833, HD4770 (830/1000):

folgt...

(Geändert von spraadhans um 21:41 am Dez. 12, 2009)

-- Veröffentlicht durch smoke81 am 16:44 am 12. Dez. 2009

Wir wollen Ergebnisse sehen! :niko:

-- Veröffentlicht durch spraadhans am 20:02 am 11. Dez. 2009

Hab schon runter geladen...;)

-- Veröffentlicht durch smoke81 am 19:45 am 11. Dez. 2009

spraad, lass doch mal Dein neues Sys bisserl arbeiten mit dem Benchmark! :niko:

-- Veröffentlicht durch rage82 am 7:58 am 9. Dez. 2009

aktuell hab ich turbo aus, weil ich den bclk auf 195 und deshalb den multi auf 18 gesenkt habe.

bei 166mhz bclk und turbo an wird der turbo-multi einfach wie ein nomaler multiplikator verwendet, also springt er zwischen 9 und 21 hin und her. damit ist die antwort auf deine frage sozusagen: ja :)

wenn ich heute abend zeit habe, teste ich mal mit standardtakt.

-- Veröffentlicht durch spraadhans am 6:43 am 9. Dez. 2009

Zitat von rage82 um 18:57 am Dez. 8, 2009 turbo modus des core i5? jain. mein board reagiert beim übertakten einfach dahingehend, das es den multiplikator 21 anwendet (welcher der tm-mode multi für belastung von 3 oder 4 kernen ist). dadurch gibts auch bei stalkerscher 1 kern-belastung keine vorteile. das müsste mal jdemp mit seinem msi gd65 testen. ich hab das gigabyte p55 udm2. |

Sind die 3,5 GHz bei dir der dauerhafte Maximaltakt aller 4 Kerne ohne Turbo?

-- Veröffentlicht durch smoke81 am 21:06 am 8. Dez. 2009

Da sollte Xantus mal mit 2-3 Durchläufen testen (1680x1050, DX10.1, Medium).

Ich habe mit meinem "schnöden" Athlon X4 @ 3,12 auch bessere Min-Werte und er hat einen Phenom II X4 @ 3,7 Ghz...

-- Veröffentlicht durch rage82 am 20:58 am 8. Dez. 2009

ich hab mehr min-fps als xantus und meine 4870 ist niedriger getaktet

(Geändert von rage82 um 21:03 am Dez. 8, 2009)

-- Veröffentlicht durch smoke81 am 20:50 am 8. Dez. 2009

Zitat von rage82 um 16:25 am Dez. 2, 2009 wenn ich mir das mal so betrachte, die min-fps bei allen 4 benchmarks scheinen also cpu-limitiert zu sein. |

Wo soll hier eine CPU-Limitierung sein?

-- Veröffentlicht durch rage82 am 18:57 am 8. Dez. 2009

turbo modus des core i5?

jain. mein board reagiert beim übertakten einfach dahingehend, das es den multiplikator 21 anwendet (welcher der tm-mode multi für belastung von 3 oder 4 kernen ist). dadurch gibts auch bei stalkerscher 1 kern-belastung keine vorteile. das müsste mal jdemp mit seinem msi gd65 testen. ich hab das gigabyte p55 udm2.

-- Veröffentlicht durch spraadhans am 17:52 am 8. Dez. 2009

Hallo rage,

hast du den turbo aktiviert und wenn ja, funktioniert das mit Stalker?

-- Veröffentlicht durch Xantus am 20:35 am 2. Dez. 2009

Ach pardon, is ne 4870 mit 512mb

-- Veröffentlicht durch rage82 am 16:25 am 2. Dez. 2009

ich schätze eher die 1024er version, der mehrtakt, im vergleich zu meiner 512er, kann die mehrleistung meiner meinung nach nicht bringen.

edit: oh, beim speicher sind es mehr als 20%, dann isses doch nicht mehr so eindeutig :)

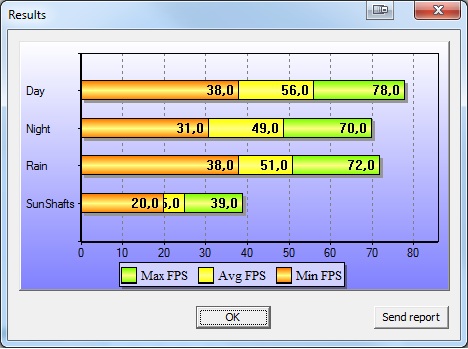

ich hab auch nochmal bissel laufen lassen

änderungen zum ersten test:

cat 9.11

cpu blck 195 statt 166, cpu weiterhin 3,5ghz

jeweils 1680*1050, dx10.1, kein AA

erster durchgang medium

zweiter durchlauf medium

und das ganze mal bei ultra

wenn ich mir das mal so betrachte, die min-fps bei allen 4 benchmarks scheinen also cpu-limitiert zu sein.

(Geändert von rage82 um 16:41 am Dez. 2, 2009)

(Geändert von rage82 um 17:02 am Dez. 2, 2009)

-- Veröffentlicht durch smoke81 am 15:22 am 2. Dez. 2009

HD4870 mit 512MB oder 1GB?

Demzufolge sind unsere Min-Frames ungefähr vergleichbar bei 1920x1080 | Ultra | DX 10.1 | 0x AA | bzw. bei mir mit 1920x1200 Auflösung. Deine avg. und max. Werte sind aber ein ganzes Stück höher.

Offensichtlich ist der GPU-Core wesentlich wichtiger bei den min-frames, als der Speichertakt. Wenn die Ergebnisse stimmen, lohnt sich ein Umstieg auf eine HD4870 keinesfalls, obwohl die meisten Benchmarks mit gemessenen Durchschnittswerten einen Performance-Vorteil von 30-40% gegenüber einer HD4850 angeben... bei den Min-Werten ist der Unterschied wesentlich geringer, entscheided also nicht über die Spielbarkeit (bzw. Unspielbarkeit).

Leider geben THG, CB und Co. in der Regel nur Durchschnittswerte an...

(Geändert von smoke81 um 15:28 am Dez. 2, 2009)

-- Veröffentlicht durch Xantus am 22:42 am 1. Dez. 2009

AMD Phenom II X3 720 @ X4 3,7Ghz

ATI Radeon 4870 512mb @ 817/1117

4GB DDR2-800

Win7 Ultimate 32Bit

1680x1050 | Medium | DX 10.1 | 0x AA |

1920x1080 | Ultra | DX 10.1 | 0x AA |

1920x1080 | Ultra | DX 10.1 | 4x AA |

1920x1080 | Ultra | DX 10.1 | 4x AA | SSAO = HDAO Ultra |

(Geändert von Xantus um 20:46 am Dez. 2, 2009)

-- Veröffentlicht durch smoke81 am 17:01 am 21. Nov. 2009

Bleiben wir doch gleich bei den Einstellungen, die sind gut für Besitzer von 22" TFTs und schwächeren Systemen, reichen aber auch aus, um stärkere Systeme zu testen:

Medium, dx10.1 in advanced options aktiviert, 1680x1050, kein AA

System:

X4 620 @ 3,12 Ghz

4GB DDR2-800

HD4850 1GB @ 700/1000

Win7 Pro x64

Cat 9.11

Min/Avg/Max

Day: 24/67/91

Night: 38/61/95

Rain: 48/65/96

SunShafts: 31/46/64

Zweiter Durchlauf 1680x1050, DX10.1:

Day: 40/67/89

Night: 43/61/95

Rain: 45/65/96

SunShafts: 33/46/64

Ausgehend von diesen beiden Messreihen ist zu vermuten, dass die CPU-Power ab einem gewissen Grundwert relativ egal ist. Auch VRAM reicht wohl ab 512MB (bei ATI) aus.

Weitere Testreihen:

Wie oben, jedoch nur mit DX10 statt DX10.1 :

Min/Avg/Max

Day: 42/67/91

Night: 45/61/96

Rain: 47/65/98

SunShafts: 31/46/64

Die Min-Werte der ersten drei Szenen sind deutlich angestiegen, die Max-Werte minimal. Der Durchschnitt bleibt jedoch gleich. In der vierten Szene sind die Messwerte absolut identisch. Ein zweiter Durchlauf des Benchmarkes mit DX10.1 (siehe oben) bestätigt, dass die Min-Werte anfangs aufgrund des parallelen Nachladens von Daten etwas zu gering ausgefallen sind, aber die Performance mit DX10 insgesamt leicht besser zu sein scheint. Der Unterschied DX10 zu DX10.1 spielt sich jedoch noch im Rahmen der Messungenauigkeit ab.

Vergleichen wir noch die Performance mit folgenden Einstellungen:

Medium, dx10.1 in advanced options aktiviert, 1920x1200, kein AA

Day: 38/60/77

Night: 38/53/81

Rain: 43/57/82

SunShafts: 29/40/52

High, dx10.1 in advanced options aktiviert, 1680x1050, kein AA

Day: 25/60/80

Night: 38/52/79

Rain: 40/55/86

SunShafts: 17/34/49

Ultra, dx10.1 in advanced options aktiviert, 1920x1200, kein AA

Day: 32/54/67

Night: 27/45/62

Rain: 22/47/77

SunShafts: 18/21/31

Bis auf Sunshafts sollte also alles einigermaßen flüssig laufen in letzter Einstellung. Es ist nur leider problematisch, dass die Performance bei ein und derselben Szene so stark wetterabhängig ist.

Das sollte erstmal reichen. Könnte jemand die letzte Einstellung

(Ultra, dx10.1 in advanced options aktiviert, 1920x1200, kein AA) mal mit einer HD4870/HD4890 testen?

(Geändert von smoke81 um 18:32 am Nov. 21, 2009)

-- Veröffentlicht durch rage82 am 18:37 am 19. Nov. 2009

Dann mal her mit euren Ergebnissen.

Ich mach den Anfang:

Medium, dx10.1 in advanced options aktiviert, 1680x1050, kein AA

die min-frames bei rain stammen daher, das er irgendwie das ganze erstmal im fenster modus hat weiter laufen lassen.

achso hardware:

core i5-750@3,5ghz

4870 512mb @standard /cat 9.9)

6gb ram

bei mir wird nur ein core wirklich ausgelastet, es sind aber alle 4 zugewiesen.

(Geändert von rage82 um 18:38 am Nov. 19, 2009)

(Geändert von rage82 um 18:43 am Nov. 19, 2009)

(Geändert von rage82 um 15:56 am Dez. 2, 2009)